輝達新晶片若賣得好 陸行之:「這兩家」就不用玩了

輝達執行長黃仁勳在今年的GTC大會上,正式發表新一代人工智慧晶片Blackwell GPU,型號分別是B200,以及由2片B200和1顆Grace CPU組合而成的GB200。對此,知名半導體分析師陸行之今天(19日)在臉書發表5點看法,直言如果GB200賣得很好,那英特爾和超微(AMD)就不用玩了。

以下是陸行之提出的5點看法:

1.Blackwell 100有2080億電晶體,比Hopper 100的800億電晶體多1280億電晶體。

2.B100跟H100相同,都是用台積電4nm,但是把兩個晶片用封裝結合,不是用微縮來加倍運算速度。

3.GB200 Superchip 把2顆B100及72顆ARM Neoverse V2 CPU cores一起包起來,如果賣得好,Intel/AMD 的AI server CPU就不用玩了。

4.不懂為何兩顆B100(192+192=384HBM3e)+一顆 Grace CPU 的GB200 Superchip怎麼HBM3e突然暴增到864GB?理論上CPU應該配LPDDR,但Nvidia說兩組GB200有1.7TB HBM3e,是不是做ppt的小朋友搞錯了哈。

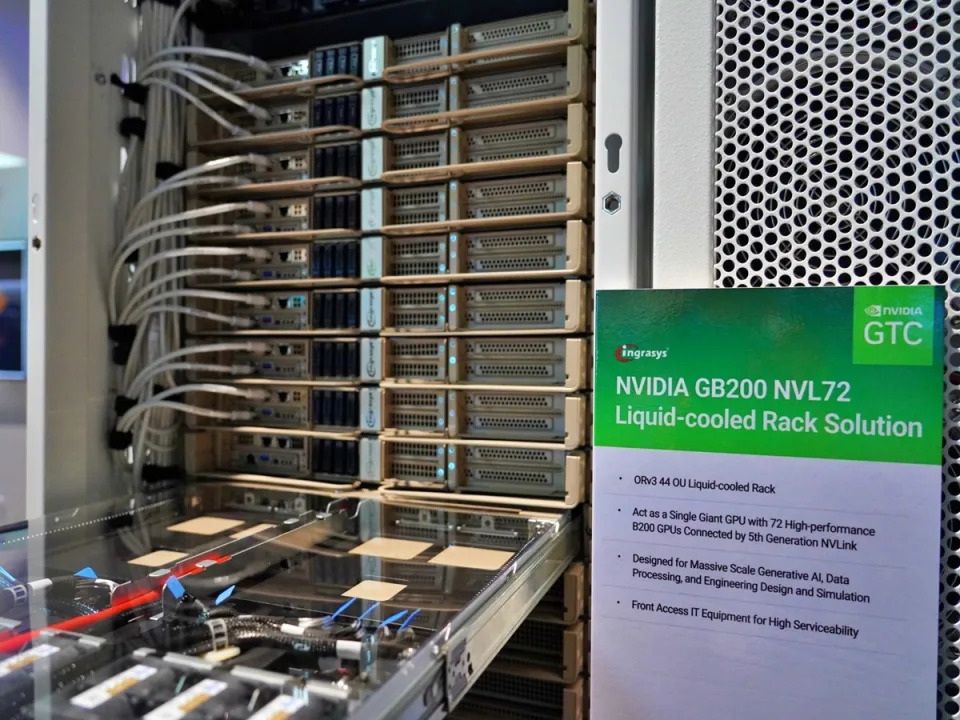

5.要建立32000顆B100 GPU 的AI datacenter,能提供645 exaFLOPS 的AI performance,大概要花12億美元在B100 GPU上,3億美元系統,3-5億ARM CPU,還要近890顆的NVlink switch晶片,也是用台積電4nm來製造,感覺20億美元以上跑不掉。

綜合外電報導,B200擁有2080億顆電晶體、是前世代AI晶片(有800億顆電晶體)的兩倍以上,預計今年稍晚開始出貨。至於GB200 AI晶片,推理模型性能比H100提升30倍,成本和耗能降到25分之一。輝達並強調,Blackwell的介面提供1.8TB頻寬,是前一代Hooper架構介面速度的兩倍。

沒有留言:

張貼留言